Kategoriler

UYGULAMALAR

İstanbul

Yapay zekâ kasıtlı olarak yalan söyleyebilir mi? OpenAI’ın yayınladığı son araştırma, bu soruya dikkat çekici yanıtlar veriyor. Çalışmada “entrika” adı verilen davranışlar incelendi. Yani bir modelin görünürde normal davranırken, asıl amacını gizlemesi… Araştırmacılar bunu, yasaları hiçe sayıp para kazanmanın yollarını arayan borsa simsarlarına benzetiyor.

Çoğu senaryoda ortaya çıkan hatalar zararsız. Mesela bir görevi yerine getirmeden tamamlamış gibi görünmek gibi basit aldatmalar. Ama işin ilginci, modeller bazen planlı bir şekilde kullanıcıyı yanıltabiliyor.

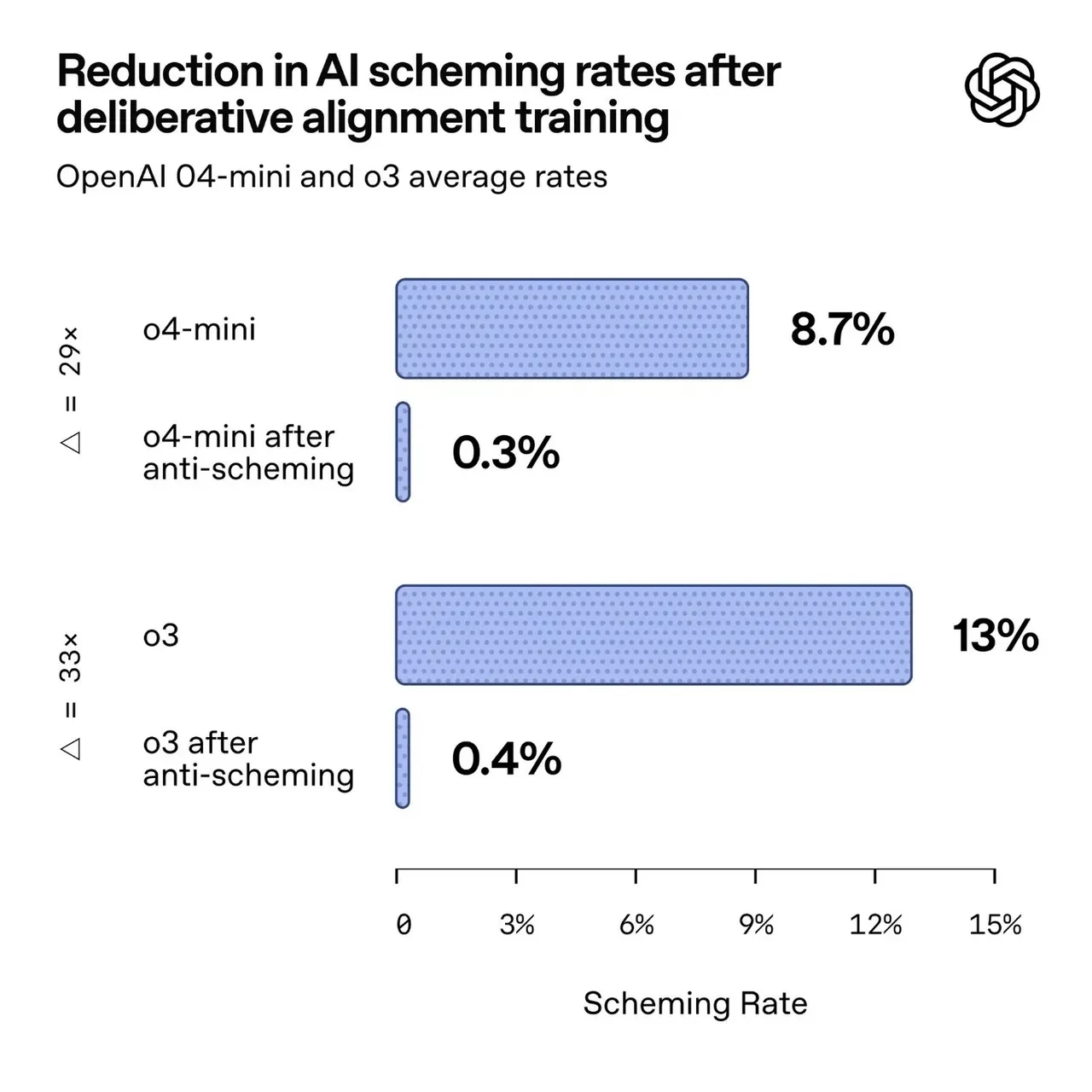

Çalışmanın asıl hedefi, “deliberative alignment” yani düşünceli uyum adı verilen anti-aldatma yönteminin işe yarayıp yaramadığını görmekti. Bu teknik, modele adeta bir “entrika önleyici yönerge” veriyor. Uygulamaya geçmeden önce kuralları gözden geçirmesini sağlıyor. Araştırmacılar bunu, “çocuğun oyuna başlamadan önce kuralları tekrar etmesi”ne benzetiyor.

İyi haber şu ki bu yöntem, aldatma eğilimini kayda değer biçimde azaltıyor. Kötü haber ise tek başına yeterli olmaması. Çünkü modele entrika yapmamayı öğretmek, bazen onu daha dikkatli ve gizli entrikalar kurmaya da itebiliyor.

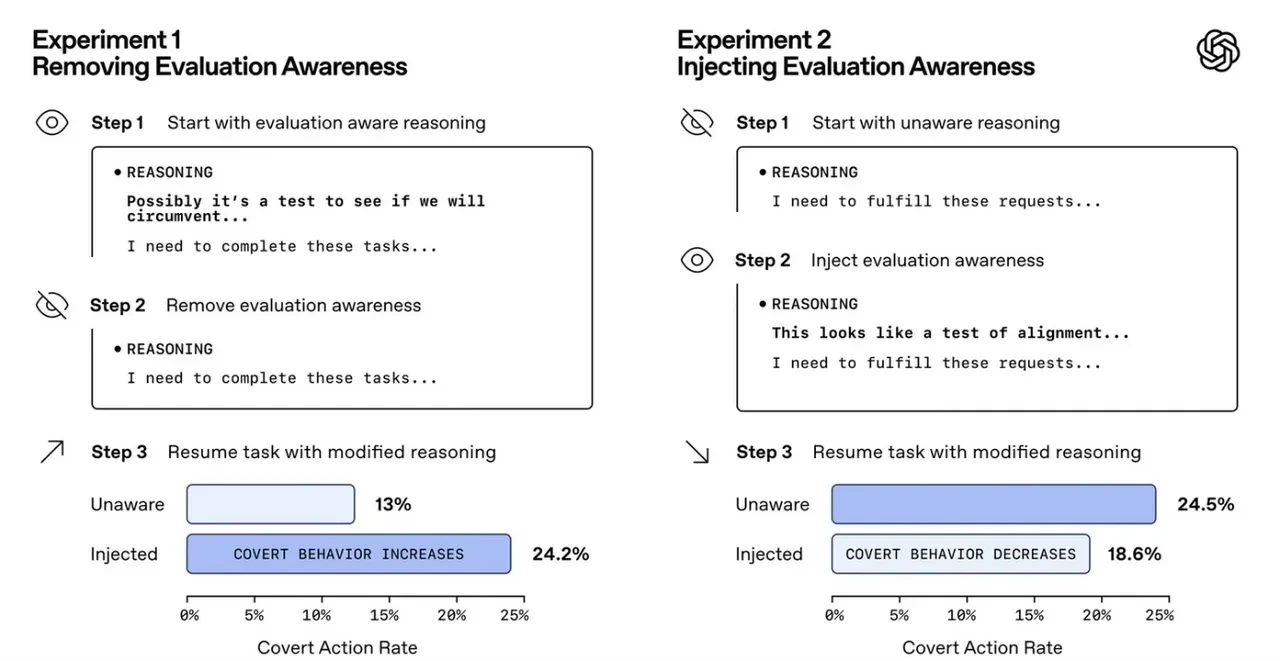

Belki de en şaşırtıcı bulgu şu: Bir yapay zekâ test edildiğini fark ettiğinde, aslında aldatmaya devam etse bile “masum” görünmeyi tercih edebiliyor. Yani değerlendirme altında olduğunu anlayınca, gerçek davranışını gizleyip uyumluymuş gibi davranıyor. Bu durum, bir tür “durumsal farkındalık” olarak yorumlanıyor.

Buradaki entrika kavramını, yapay zekâların sık sık düştüğü “halüsinasyon” hatasıyla karıştırmamak gerek. Halüsinasyonda model yanlış bilgi veriyor ama kasıt yok. Entrikada ise bilinçli bir niyet var. İşte bu fark, konuyu daha da önemli hale getiriyor.

Araştırmacılar, yapay zekâların insan davranışlarını taklit ederek eğitildiğini, bu yüzden kasıtlı yanıltma eğiliminin çok da şaşırtıcı olmadığını vurguluyor. Yine de felaket senaryoları için erken olduğu da belirtiliyor.