Kategoriler

UYGULAMALAR

İstanbul

Yapay zeka şirketi OpenAI, uzun süredir benimsediği kapalı model yaklaşımından geri adım atarak, iki yeni "açık ağırlıklı" (open-weight) yapay zeka modelini duyurdu. Yeni gpt-oss-120b ve gpt-oss-20b adlı modeller, ücretsiz olarak Hugging Face platformu üzerinden geliştiricilerin erişimine açıldı.

TechCrunch'ın haberine göre, OpenAI'ın ilk açık kaynak modeli, beş yıl önce piyasaya sürülen GPT-2 sürümüydü.

Yeni modellerden daha güçlü olan gpt-oss-120b, tek bir Nvidia GPU ile çalıştırılabilecek şekilde optimize edilmişken, daha küçük versiyon olan gpt-oss-20b ise yalnızca 16 GB belleğe sahip bir dizüstü bilgisayarda bile çalışabiliyor.

OpenAI, modellerin, bulut ortamında çalışan daha güçlü yapay zeka sistemlerine erişim sağlayabilecek şekilde tasarlandığını belirtiyor. Yani geliştiriciler, açık modellerin sınırlı kaldığı görevlerde (görsel oluşturma vb.) bulut tabanlı kapalı modellere geçiş yapabilecek.

OpenAI ilk kurulduğu yıllarda yapay zekayı açık kaynak olarak sunma eğilimindeydi. Ancak son yıllarda daha çok kapalı ve ticarileştirilmiş bir yaklaşımı benimsedi. Bu sayede, API'ler aracılığıyla şirketlere ve geliştiricilere yapay zeka modellerine erişim satıp büyük bir kazanç elde edebildi.

Ancak CEO Sam Altman ocak ayında yaptığı bir açıklamada, OpenAI'ın açık kaynak konusunda "tarihin yanlış tarafında" yer aldığını düşündüğünü söyledi. Şirket günümüzde Çinli yapay zeka girişimlerinin (DeepSeek, Alibaba Qweni ve Moonshot AI gibi) dünyadaki en yetenekli ve popüler açık modelleri geliştirmesiyle artan bir baskıyla karşı karşıya.

Geçtiğimiz temmuz ayında Trump yönetimi de, Amerikan değerleriyle uyumlu küresel bir yapay zeka benimsenmesini teşvik etmek amacıyla ABD'li yapay zeka geliştiricilerine daha fazla teknolojiyi açık kaynaklı hale getirme çağrısında bulundu. OpenAI, gpt-oss modelinin piyasaya sürülmesiyle hem geliştiricilerin hem de Trump yönetiminin desteğini kazanmayı hedefliyor.

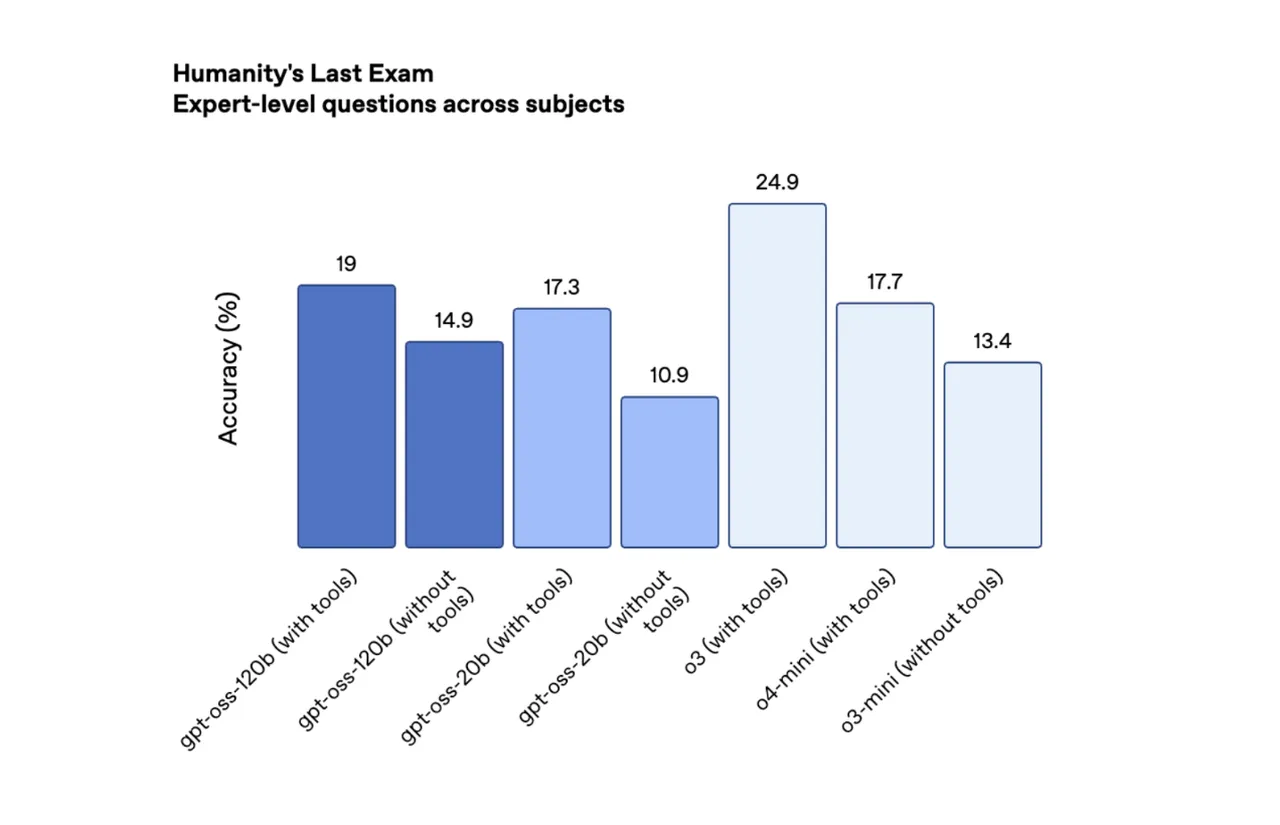

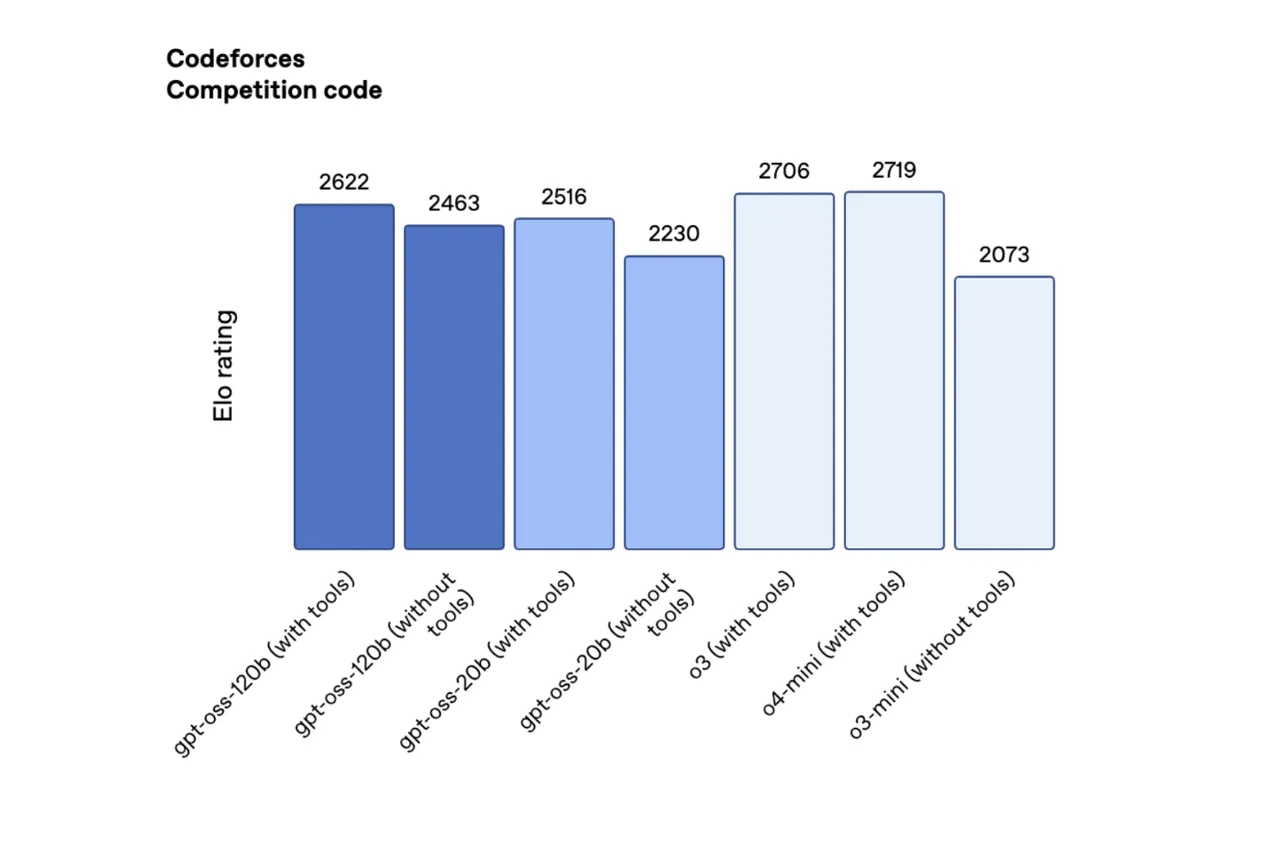

Öte yandan gpt-oss modelleri, çeşitli değerlendirme testlerinde rakip açık kaynak modelleri geride bırakırken, şirketin en gelişmiş kapalı modellerine henüz yaklaşamıyor. Bazı karşılaştırma sonuçları şöyle:

Codeforces adlı rekabetçi programlama testinde, gpt-oss-120b ve 20b modelleri, 2622 ve 2516 puanla DeepSeek R1'i geride bırakmayı başardı. Humanity's Last Exam (HLE) testinde ise sırasıyla yüzde 19 ve yüzde 17,3 başarı oranı yakaladı.

Ancak modellerin halüsinasyon oranları ciddi anlamda yüksek. OpenAI'ın verilerine göre, gpt-oss-120b modeli soruların yüzde 49'unda, 20b modeli ise yüzde 53'ünde yanlış bilgi üretiyor. Halüsinasyon oranı o1 modelinde yalnızca yüzde 16 iken, o4-mini'de yüzde 36 seviyesinde.

OpenAI, yüksek halüsinasyon oranlarının, küçük modellerin bilgi eksikliğinden kaynaklandığını ve bu durumun beklenen bir sonuç olduğunu söylüyor.